Нелинейность: Может ли линейная регрессия конкурировать с градиентным бустингом?

Нейросети и автоматизация

Когда разговор заходит о современных технологиях, модели машинного обучения остаются в центре внимания. В особенности, когда речь идет о двух разнополярных великанах: линейной регрессии и градиентном бустинге. На первый взгляд они могут показаться похожими, но если заглянуть глубже, становится очевидным, что это два совершенно разных подхода к работе с данными, особенно когда эти данные имеют причудливые, не линейные связи. Давайте разбираться!

Линейная регрессия: основа основ

Линейная регрессия — это та база, на которой стоит большинство моделей машинного обучения. Многие начинают с нее, ведь она простая и, по сути, интуитивно понятная. Она предполагает, что между признаками и выходом есть прямая связь. Вспомните школьную математику: график линейной функции — это прямая линия.

Ключевые характеристики линейной регрессии

- Линейность: Как уже говорилось, в основе линейной регрессии — прямая. Если ваши данные не поддаются этому, готовьтесь к борьбе.

- Интерпретируемость: Сложнее не придумаешь: изменение одной переменной влияет на результат, и можно легко проследить связь. Хотите увидеть, как увеличивается зарплата с каждым дополнительным годом стажа? Линейная регрессия позволит вам это сделать.

- Простота: Надо быстро получить прогноз? Линейная регрессия — идеальный кандидат. Никаких сложных манипуляций.

Линейная регрессия и ее недостатки в мире нелинейности

Вот мы плавно переходим к тому, в чем же проблема? Да, в том, что реальная жизнь редко бывает линейной. Тут-то и начинается волшебство: давайте использовать различные приемы, чтобы подогнать линейную регрессию под эти кривые линии.

Шарим на коленке

- Полиномные признаки: Добавим немного магии – полиномиальные признаки! Если ваша зависимость выглядит как квадратичная функция, то простым включает x² в модель, и вы закиваете с удовлетворением.

- Логарифмическая трансформация: Логарифмирование признаков может помочь линейной модели справиться с проблемами неровностей. Вдруг ваши данные окажутся в более удобоваримом виде?

Пример простой жизни: если у вас есть уравнение вида ( y = ax^2 + bx + c ), добавьте ( x^2 ) и смотрите, как возвращается улыбка на лица аналитиков. Признаки становятся более подходящими, и линейка вроде как справляется.

Градиентный бустинг: новая звезда на горизонте

А теперь давайте обсудим градиентный бустинг. Это не просто элегантный метод, а настоящая многослойная закуска для ваших данных. Он способен справляться с нелинейными отношениями без каких-либо жарких дебатов и манипуляций.

Ключевые характеристики градиентного бустинга

- Нелинейность: Он как швейцарский нож, который автоматически понимает, когда дело доходит до нелинейных зависимостей. И никаких дополнительных операций не требует!

- Гибкость: Работает с различными функциями потерь, так что вам не придется прятаться от ваших данных.

- Устойчивость: Забудьте о выбросах и пропусках: градиентный бустинг не боится ни того, ни другого.

Как работает градиентный бустинг?

Давайте немного разберем процесс. Первое, с чего все начинается — это наивное предсказание, иначе называемое средней величиной. Делаем выводы по этому предсказанию и… на счастье строим новый слабый модель. И так по кругу, делая каждое новое предсказание все более точным, пока не приближаемся к идеалу.

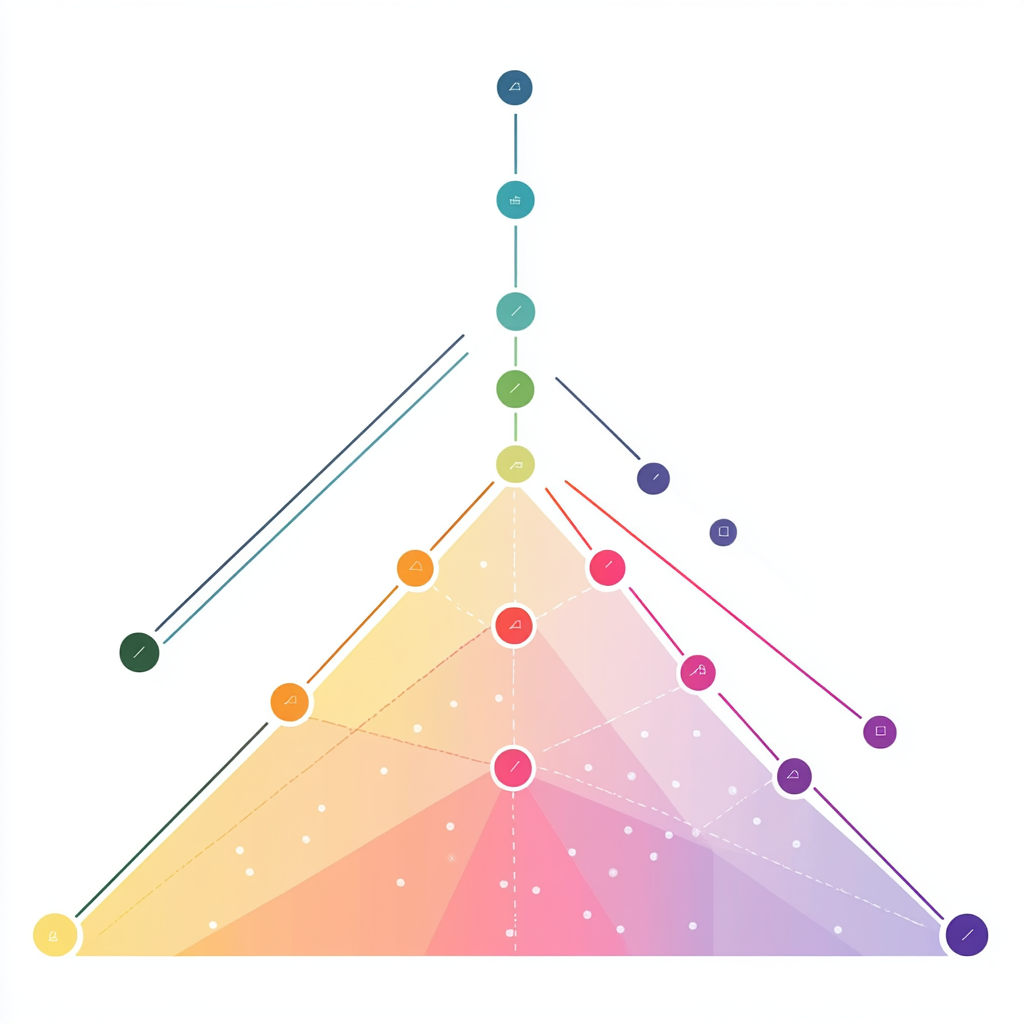

Сравнение: линейная регрессия против градиентного бустинга

Давайте напрячем мозги и сравним наших героев.

Как они справляются с нелинейностью

- Линейная регрессия: Ждет, когда вы попросите ее подправить свои привычки. Кажется, что о ней забыли про нелинейные зависимости — это как набрать вес и при этом притягиваться к тонким брюкам.

- Градиентный бустинг: Он словно как тот уникум, который все понимает, даже даже когда вы сами не понимаете. Вошел в комнату — затушил свет, пока линейка дрожит от собственных многочленов.

Интерпретируемость

- Линейная регрессия: Прямо как учитель математики, все объяснит разжеванно и с примерами. Вам никогда не станет скучно, когда вы понимаете, как одни переменные влияют на другие.

- Градиентный бустинг: Тут уж не все так просто. Он как хитрый трюк. Есть значимости признаков, но рассмотреть всю эту «интерпретируемую сложность» сложно. Хотя со временем можно прикоснуться к его тайнам.

Выполнение

- Линейная регрессия: Да, ты хорош в своем стиле. Но когда дело доходит до сложных, заковыристых задач, надо перевести от скуки к чему-то более серьезному.

- Градиентный бустинг: Часто оказывается на вершине рейтинга, когда дело касается сложных взаимосвязей. Каждый раз, когда начинает хмуриться, он углубляется в сложные подлупы данных и подает результаты, которые радуют глаза.

Практический пример для душевного комфорта

Предположим, вы правите совершенно миром, а под вашим контролем — рынок недвижимости. Хочется предсказать цену на дома, опираясь на такие факторы, как состояние домов, количество комнат и местоположение. Линейная регрессия здесь может дать сбой, как неудачная шутка на вечеринке. А вот градиентный бустинг покажет, что его любимости не зря выжигаются. Он учует каждую нелинейность и предоставит вам более точный прогноз, радуя ваш ум.

Заключение

Линейная регрессия может быть вашей верной подругой, но только для тех случаев, когда все просто и понятно. Если же ваши данные полны неожиданных поворотов и капризов, градиентный бустинг — ваше лучшее решение. Откройте для себя его возможности и позвольте сложным взаимосвязям создать пронзающий комплекс картиной данных.

И не забывайте: актуальные новости о нейросетях и автоматизации ждут вас! Подписывайтесь на наш Telegram-канал: @neuroko.